4월 첫째 주

읽은 논문

- Attention is all you need

완전히 이해함. 누가 물어봐도 설명 가능

읽고 싶은 논문

기존 내용 접기/펼치기 버튼

글을 사진으로

노트 제목 : nlp 함치기 (03.16)

nlp 수업 듣다가 그냥 막 이것저것 합쳐서 그려봄. 구체화해보고 싶다면...

- CLIP: Connecting Text and Images https://arxiv.org/abs/2103.00020 블로그 https://openai.com/blog/clip/

사진 각도를 바꿔보자.

노트 제목 : gan회전(03.05) , 차원을 늘리면?(03.21)

gan 회전은 wgan 읽고 두가지 방식의 거리를 적절히 혼용해볼 생각을 했었음. 구에다가 맵핑 시키면 어떨까 하는 이야기가 나옴.

- Sphere Generative Adversarial Network Based on Geometric Moment Matching

- HoloGAN

차원을 늘리는 생각은 조금 더 구체화 해봐야 하지만 - Nerf, Nerf++. nerf-- 얘네랑 비슷한 개념. -> https://github.com/yj-uh/vi-lab/issues/26#issuecomment-792227996

- [ ] https://arxiv.org/abs/2103.07751 이것도 참고하자. Unsupervised Image Transformation Learning via Generative...

Contrastive랑 GAN이랑

- [x] Training GANs with Stronger Augmentations via Contrastive Discriminator (https://arxiv.org/abs/2103.09742)

중요 포인트를 태우자

노트 제목 : 패치 트랜스포머?

Vision Transformer (VIT) 보고 떠올림 이미지 패치로 넣는데 이걸 좀 다른 영역도 같이 넣어주면 좋을텐데... 라는 것임. 구체화된 생각 하나도 없음.

focus 된 convolution 관련 논문으로

- Deformable Convolutional Networks

AE 또는 VAE랑 GAN을 합치면?

노트제목 : 이게뭐람(03.19)

- introvae https://arxiv.org/abs/1807.06358

- adversarial autoencoder https://arxiv.org/abs/1511.05644

- bigan https://arxiv.org/abs/1605.09782

흑인 왜 없음

- Reliable Fidelity and Diversity Metrics for Generative Models

제대로 안읽어봤으니 읽어보자... - Extended Isolation Forest

분류를 이렇게도 할 수 있더라 읽어보자.

K-means 하면서 classification

노트제목 : 크게 분류해보면서 작은걸로

- SWAV

- Towards Open World Object Detection 참고

- Network dissection

- GAN dissection

구현한 논문

없음.

DCGAN

(code) - 구현 코드 저장 repo

구현중인 논문

우리 세미나 task!! 해야했는데 다른데 꽂힘..

(code) - 구현 코드 저장 repo

로그에 정리해보는 연구 진행 사항

- 아이디어 : 어두울 때 색 정보를 추측하는 네트워크를 제일 앞단에 태워보자.

1차 간단하게 만들어 CIFAR10에 돌려봄.

백본 : efficientnetb0 (오피셜코드 X)

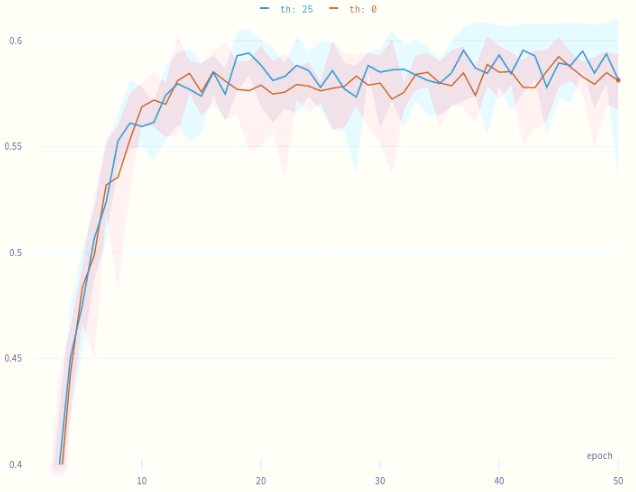

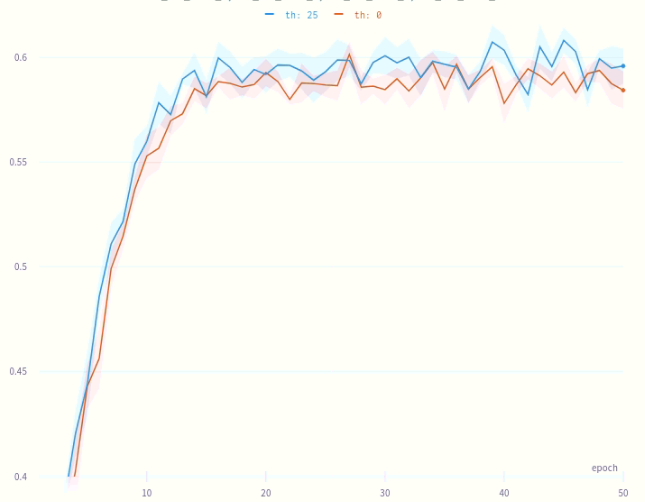

성능 향상이 있는 것으로 보임. Threshold를 다양하게 잡아가며 진행. 20이하는 성능이 그닥 안나오고 100 이상도 안나옴.다양한 네트워크에 적용.

CIFAR10의 경우 ResNet을 제외하고 성능 향상이 있었음.설계 오류 발견.

정민님과 이야기 하던 중 잘못된 부분 발견. 해당 부분을 고치니 성능이 안나옴. => 미궁에 빠짐.정말 다양한 시도를 통해 맞는 설계 + 의도하던 바 대로 네트워크를 구축함. + STL10을 사용하여 테스트해보기로 바꿈 (cifar10은 명암이 너무 적다는 생각이 들었다.) 그 결과 th가 20~30 정도일 때 효과가 보임.

validation dataset이 따로 없고 나누기 귀찮아서 그냥 매 epoch 마다 test 셋을 한번씩 돌려서 acc를 측정해봤다.

- GoogleNet

- AlexNet

- VGG19

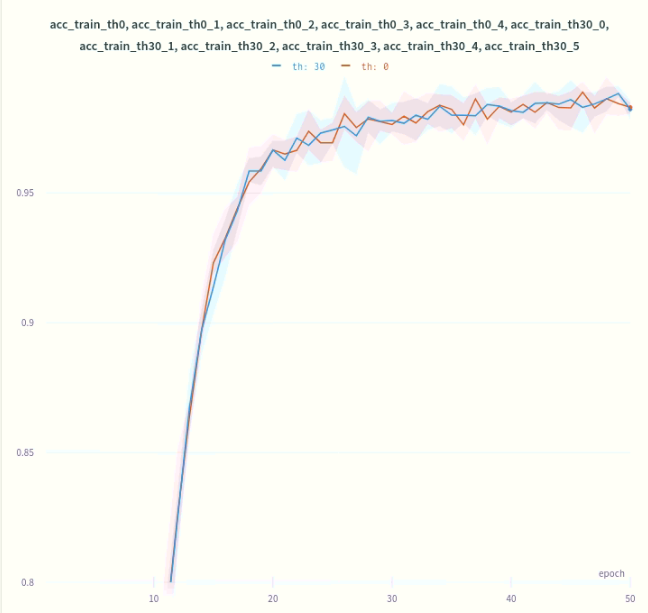

각각 6번의 학습 결과를 평균 낸 그래프이다. (th 0는 날 것 그대로) 모두 End to End로 학습하였으며 드라마틱한 성능 향상은 아니지만 분명 약간씩의 상향된 느낌이 존재한다.

추가적으로 train loss 및 train acc는 전혀 늘지 않았다.

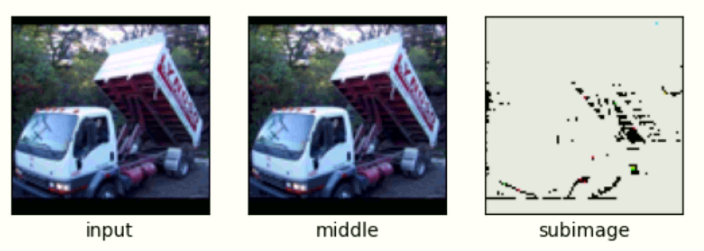

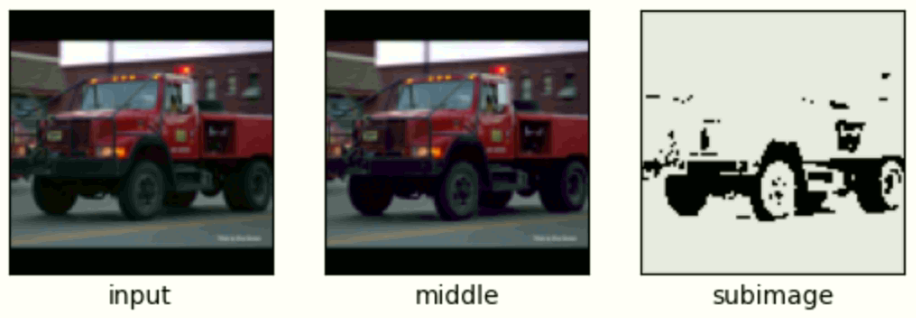

또한 사람의 눈으로는 구별되지 않는 정도의 효과가 적용된 것을 볼 수 있다. 바뀌는 것이 거의 없다. (밑의 사진은 많이 바뀐 편이다.) 그럼에도 성능이 좋아진다는 것이 신기할 따름이다.

+차의 백미러 쪽은 충분히 어두움에도 불구하고 아무런 값이 더해지지 않았다. ?! 신기하군

가끔 구별되는 경우도 보인다.

- 총평

시간을 꽤 많이 쏟았다... 변수도 이것 저것 정말 많이 건들여 봤고 하나하나씩 바꿔가면서 여러 시도를 해봤다. (그러다가 서버 메모리를... 죄송합니다)

코드도 정리해서 어떤 모델이든 적용 가능하도록 만들었다. (이미지를 넣는 모든 모델에 적용 가능하다)

분명 acc가 증가하는 듯 한데 엄청난 증대는 아니여서 의미가 있을지는 모르겠다.

- ResNet의 경우 별반 차이가 느껴지지 않는다. ResNet18을 사용하였는데 너무 불안정한 느낌을 받았다. 수렴이 매우 빠르다. 그 후 왔다갔다가 극심하다. 저 드넓은 배경의 색을 보라. 6번 평균을 낸 그래프도 진동이 심하다. 그래도 성능 하락은 없다. 숫자를 올려서 조금 더 깊은 네트워크를 다음에 사용해 보려 한다..

- 일단 여기서 멈췄다. 할일을 많이 미뤄놨다... 다음에 이어서 해야할 듯 하다.

지난주 계획 체크

계획이고 뭐고 위에 잔뜩 적어놓은 연구만 했다... 다음주가 바빠질 예정...

- 위에 적힌 논문 목록중에 2개는 지워보자.

- 자연어처리를 위한 딥러닝 수업 논문 살펴보기 (화)

- 딥러닝기반컴퓨터비전특론 수업 논문 살펴보기 (수, 목)

- 랩 코딩 해보기 (금)

- 랩세미나 논문 읽기 (금)

- Color constancy 관련 연구 코드 짜기 (토, 일)

- 운동 및 영어공부

- 다음주 Weeklog는 시간 들여서 논문 정

- 총 평

하지만 만족스럽다.

계획

1주일간 해야할 일 우선순위 + 기한 별 나열. (괄호 내 기한)

- 자연어처리 발표

- 딥러닝이론 과제

- LGD 코딩

- 딥러닝기반컴퓨터비전특론 발표 준비.

- 논문 2개 읽기.